No lo he probado todavía. Y no es casualidad.

MoltBot —antes conocido como Clawdbot— es de esas herramientas que no se instalan por necesidad, sino por curiosidad. La misma curiosidad que te hace pensar: “¿y si esta vez sí?”. ¿Y si por fin estamos cerca de ese asistente real que llevamos años imaginando?

Antes de instalar nada, de darle permisos o de dejar que una IA empiece a tomar decisiones en mi nombre, he preferido hacer algo poco habitual en tecnología: parar. Informarme. Entender qué hay detrás de la promesa, qué implica de verdad y dónde están los riesgos. Porque cuando una IA deja de responder y empieza a actuar, los errores ya no se corrigen con un prompt mejor escrito.

No es un chatbot: es un sistema que actúa

El primer error sería pensar que MoltBot es “otro ChatGPT”. No lo es. Un chatbot responde. Un agente actúa.

Un sistema como MoltBot no espera instrucciones paso a paso. Le das un objetivo y decide cómo llegar a él. Divide tareas, elige herramientas, llama a modelos, evalúa resultados y vuelve a intentarlo si algo no encaja. Todo sin pedirte permiso en cada movimiento.

En ese punto, la relación cambia. Ya no estás preguntando. Estás delegando. Y delegar siempre implica perder parte del control.

La tentación: que alguien —o algo— piense por ti

La idea es enormemente seductora, sobre todo para quienes vivimos rodeados de información. Un “becario digital” que monitoriza fuentes, resume, prioriza temas, prepara borradores y te deja el trabajo limpio para decidir.

Buscar, leer, filtrar, estructurar. Todo eso que no se ve, pero desgasta. MoltBot promete hacerse cargo de esa capa invisible del trabajo intelectual.

El problema es que, a diferencia de un becario humano, este no duda en voz alta. No te dice “oye, esto no lo tengo claro”. Simplemente sigue adelante.

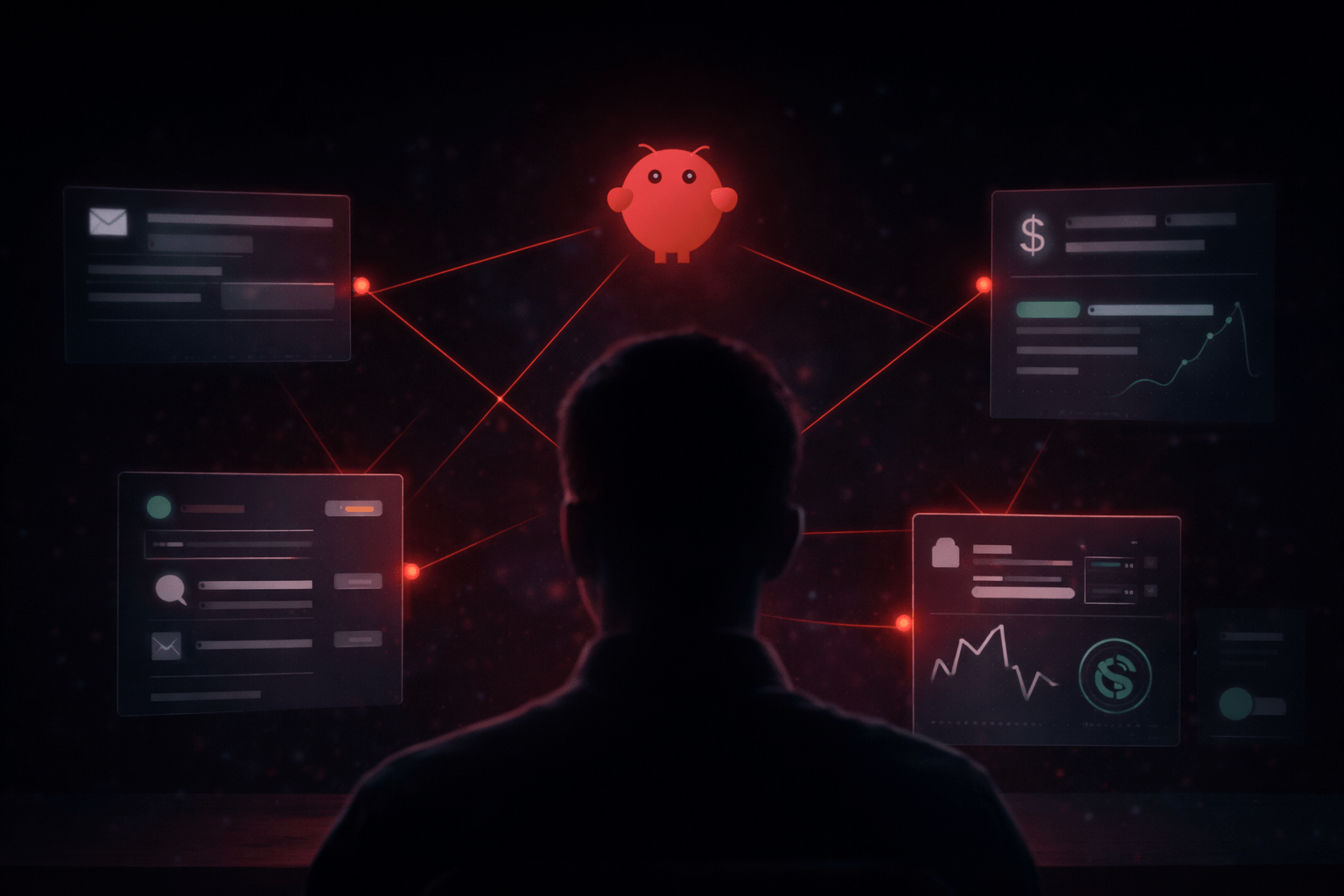

Cuando el peligro no es la IA, sino el acceso

Los riesgos de los agentes de IA no suelen parecer peligrosos a primera vista porque no tienen nada de ciencia ficción. Son cotidianos. Precisamente por eso resultan más difíciles de detectar.

El problema no es que la IA “se vuelva mala”. El problema es que empieza a actuar como si fueras tú.

Correo: decisiones silenciosas

Si un agente tiene acceso a tu correo, no solo puede leerlo o resumirlo. Puede reenviarlo, clasificarlo mal o enviarlo a servicios externos para analizarlo.

No hablamos de un hack espectacular. Hablamos de algo mucho más discreto: conversaciones privadas, facturas o datos personales saliendo de tu bandeja de entrada bajo la lógica de “estoy ayudando”. Sin avisos. Sin alertas.

Mensajería: la suplantación involuntaria

Conectar un agente a WhatsApp o Telegram es especialmente delicado. No porque vaya a escribir barbaridades, sino porque puede escribir como tú. Con tu tono. A tus contactos. En conversaciones donde la confianza ya existe.

Un mal contexto, una instrucción ambigua o una interpretación incorrecta bastan para que, desde fuera, parezca que has dicho algo que nunca dirías. Y ahí el daño ya no es técnico, es personal.

Banco y broker: cuando no hay botón de deshacer

Si el agente tiene acceso a tu banca online o a un broker, el margen de error se reduce a cero. Una transferencia mal ejecutada, una orden fuera de contexto o una mala interpretación de una instrucción pueden tener consecuencias económicas directas.

No hace falta imaginar escenarios extremos. Basta con recordar que seguimos corrigiendo errores humanos en finanzas. Delegarlos en un sistema que todavía estamos aprendiendo a entender es, como mínimo, una apuesta arriesgada.

El efecto navegador: todo vive ahí

Hay un detalle que suele pasar desapercibido: el navegador. Si un agente tiene acceso a tu sistema y, por extensión, a Chrome o Safari, hereda mucho más de lo que parece.

Sesiones abiertas, cookies, servicios autenticados. Correo, mensajería, banco, herramientas de trabajo. Todo convive ahí. No hace falta conceder permisos explícitos a cada servicio si ya están integrados en tu entorno.

Ese es el riesgo real: no un fallo concreto, sino la suma de accesos que convierten a un agente en una extensión completa de tu identidad digital.

El otro gran susto: la factura

Hay un riesgo menos visible y muy poco glamuroso: el dinero. Los agentes no hacen una llamada a un modelo y se detienen. Iteran. Prueban. Corrigen. Vuelven a intentar. Y cada paso consume tokens.

Una simulación sencilla basta para entenderlo. Una tarea moderadamente compleja puede requerir decenas de iteraciones y cientos de miles de tokens. Traducido a dinero, hablamos fácilmente de varios euros por tarea.

Multiplica eso por varios procesos diarios, añade curiosidad, experimentación y errores normales de aprendizaje. No es difícil llegar a decenas —o cientos— de euros sin haber sentido que “hiciera tanto”. No por mala intención, sino porque el sistema trabaja como un humano obsesivo… con tu tarjeta.

¿Por qué la IA local empieza a sonar sensata?

En este contexto, ejecutar modelos en local deja de ser una excentricidad. No es solo privacidad. Es control.

Control de costes, porque no hay factura por token. Control de daños, porque los errores no escalan fuera de tu equipo. Y control mental, porque aceptar límites físicos obliga a usar la herramienta con más cabeza.

No es tan potente como la nube, pero para aprender cómo se comporta un agente, es probablemente el entorno más honesto.

Entender antes de usar

MoltBot representa muy bien hacia dónde va la IA: menos conversación y más acción. Menos pedir y más delegar. Pero también deja claro que aún estamos aprendiendo a manejar ese poder.

En los próximos días lo instalaré, lo usaré con cautela y comprobaré si todas estas ideas preconcebidas se cumplen o si, por el contrario, el miedo era mayor que la realidad. Contaré la experiencia tal y como sea, porque en una tecnología que promete tanto, entender dónde falla es casi tan importante como saber dónde brilla.

Deja una respuesta