En las últimas semanas han coincidido dos noticias que, vistas por separado, podrían parecer anecdóticas. Juntas, dibujan algo mucho más serio.

En España, el Gobierno ha anunciado su intención de prohibir el acceso a redes sociales a menores de 16 años y perseguir la amplificación de contenidos ilegales. En Francia, las autoridades han ido un paso más allá y han citado a Elon Musk en el marco de una investigación sobre los algoritmos de X.

No es casualidad. Es un cambio de etapa. Los Estados han empezado a mirar las redes sociales como antes miraron a los medios de comunicación tradicionales: no solo por lo que se dice en ellas, sino por cómo se distribuye.

El gran malentendido: culpar al algoritmo

Durante años hemos repetido que el algoritmo es el villano. El ente opaco que decide qué vemos, qué se amplifica y qué desaparece. Pero el algoritmo no piensa, no opina y no conspira. El algoritmo reacciona.

Responde a señales muy concretas: volumen, velocidad, repetición y carga emocional. Si de repente hay ochenta cuentas compartiendo el mismo insulto, la misma mentira o la misma provocación, el sistema no se pregunta si es verdad, si es justo o si es ético. Interpreta que eso genera interacción y lo empuja hacia más gente.

No porque tenga ideología, sino porque está diseñado para detectar movimiento.

El algoritmo no crea mensajes. Amplifica señales.

El verdadero combustible del caos digital

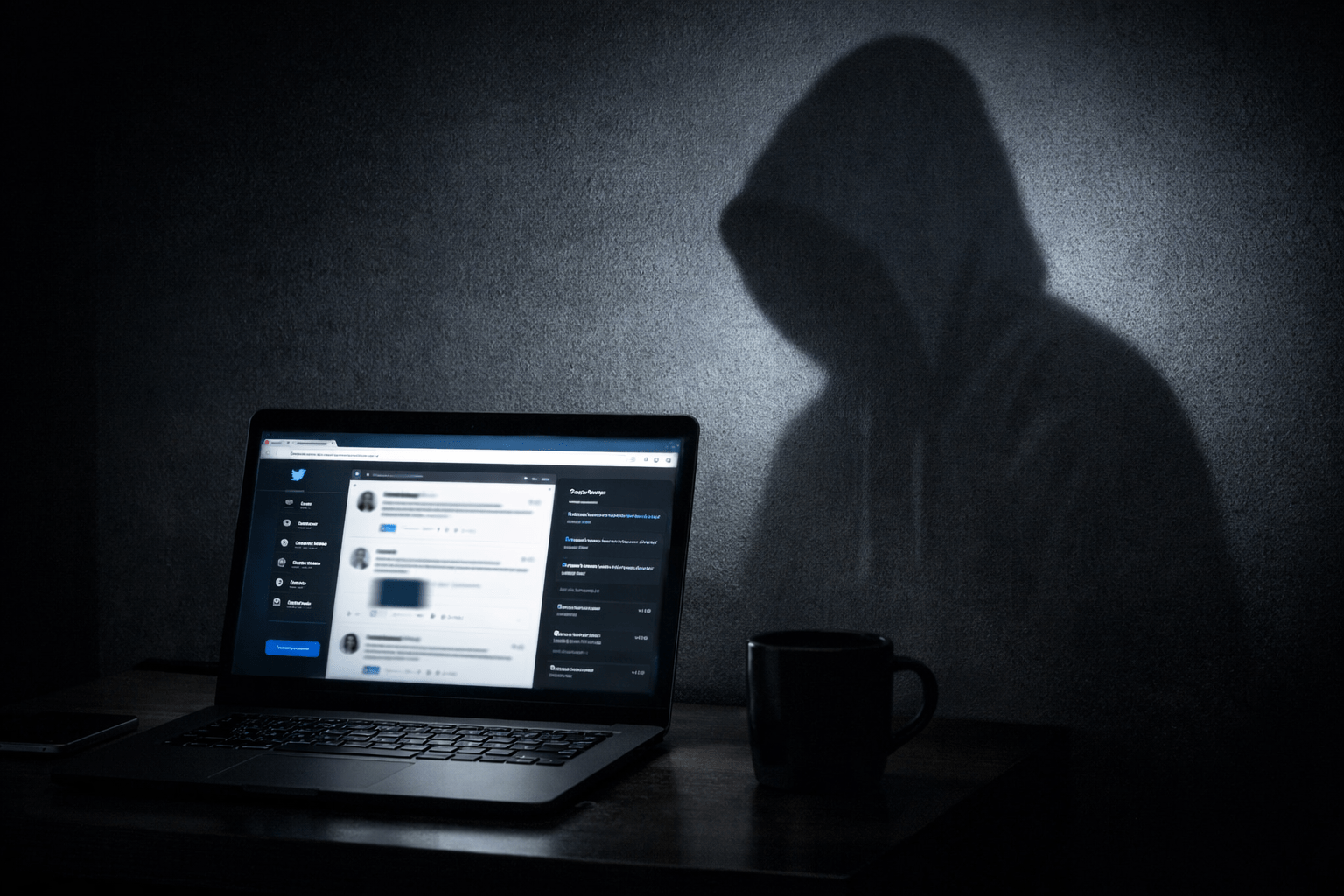

Las cuentas falsas no son un detalle técnico ni un efecto secundario molesto. Son la infraestructura básica de casi todo lo que luego denunciamos como toxicidad en redes sociales.

El odio organizado no vive de opiniones expresadas a cara descubierta, sino de perfiles desechables que insultan sin coste y reinciden sin consecuencias. El grooming y la pedofilia digital no existirían a la escala actual sin identidades falsas que se hacen pasar por menores y desaparecen al primer aviso. Las estafas, la piratería y las campañas de desinformación se sostienen sobre la misma lógica: anonimato, coste cero y coordinación.

No es que la sociedad sea de repente más violenta o más radical. Es que el sistema permite amplificar a quien no tiene nada que perder.

Multar plataformas es tratar el síntoma

Exigir a las plataformas que retiren contenidos ilegales es lógico. Sancionarlas cuando miran hacia otro lado ante abusos claros también lo es. Eso no es censura, es cumplimiento de la ley.

Pero multar a X, Meta o TikTok no ataca la raíz del problema. Es apagar incendios sin cerrar la gasolinera. Mientras crear una cuenta falsa siga siendo rápido, barato y prácticamente anónimo, el patrón se repetirá una y otra vez.

Se castiga al altavoz, pero no a quien grita.

Proteger al menor no se discute. El método, sí

Conviene decirlo sin rodeos: existen estudios serios que relacionan el uso intensivo de redes sociales a edades tempranas con problemas de salud mental, ansiedad, alteraciones del sueño y mayor exposición a riesgos. El grooming, la pornografía infantil y el contacto no deseado son realidades documentadas, no exageraciones morales.

Proteger a los menores es legítimo y necesario. Punto.

Pero precisamente por eso es un argumento tan potente como peligroso. Porque cuando nadie puede oponerse al objetivo, el debate se desplaza al método.

Perseguir contenido ilegal es una cosa. Perseguir “algoritmos que amplifican” sin definir con precisión qué significa amplificar es otra muy distinta.

Libertad de expresión: la línea que no se puede cruzar

La libertad de expresión no es un eslogan. Es una válvula de seguridad. Y es justo aquí donde aparece el verdadero miedo.

El mismo argumento que sirve para perseguir delitos reales puede usarse también para algo mucho más turbio: perseguir disidencia. No hace falta prohibir una idea para censurarla. Basta con etiquetarla como problemática o peligrosa y dejar que la maquinaria haga el resto: menos alcance, menos visibilidad, menos conversación.

Cuando la frontera entre lo ilegal y lo incómodo se vuelve difusa, el margen para el abuso se dispara. Y el problema no es solo lo que haga un gobierno concreto hoy, sino el precedente que deja para el siguiente.

La libertad de expresión no muere cuando la prohíben. Muere cuando da miedo ejercerla.

Identidad no es censura

Identificarse para crear una cuenta no es censura. Es asumir que el espacio digital ya no es un juego, sino una extensión de la vida real.

En la calle no insultamos, no amenazamos y no estafamos masivamente no porque seamos mejores personas, sino porque hay consecuencias. Nombre, rostro y responsabilidad. En internet hemos normalizado lo contrario: anonimato absoluto combinado con alcance masivo.

No se trata de eliminar el anonimato público, sino de que detrás de cada cuenta exista una identidad trazable para la ley.

Si decir algo en internet tuviera consecuencias parecidas a decirlo en la vida real, las redes serían espacios mucho más tranquilos.

El riesgo de fondo

Regular redes sociales no es malo en sí mismo. No regularlas tampoco. El riesgo real es normalizar sistemas opacos donde nadie decide explícitamente, pero todos sienten el efecto.

Donde la protección del menor se convierte en coartada para controlar el mensaje. Donde se culpa al algoritmo de un problema profundamente humano.

No necesitamos algoritmos más morales. Necesitamos identidades más responsables.

Porque el algoritmo no es el problema.

El problema es a quién dejamos hablar sin rostro ni consecuencias.

Deja una respuesta